Arama motoru botlarının bir internet sitesini ziyaret ederek web sayfalarını indirme ve okuma sürecine crawl (tarama) denir ve Google’ın her bir internet sitesini taramak, indekslemek ve sıralama sonuçlarında yer vermek adına ayırdığı zaman yani crawl budget (tarama bütçesi) farklıdır.

Küresel ölçekte milyarlarca internet kullanıcısının ihtiyaçlarına yönelik sıralama sonuçları listelemeyi hedefleyen Google, tarama bütçesini değerli olarak nitelendirdiği internet sitelerine yönlendirerek kullanıcılarına aradıkları sonucu mümkün olan en kısa sürede ve en doğru şekilde göstermeyi amaçlar.

Dolayısıyla bu yaklaşımdan çıkaracağımız sonuç; Google’ın internet sitemizi taramak, indekslemek ve anlamlandırmak adına ayırdığı tarama bütçesinin artış göstermesi, çoğu zaman dizindeki değerimizle doğrudan ilgilidir olacaktır. Elbette bu değeri belirleyen yüzlerce majör ve minör faktör vardır ve bu faktörlerin bütünü de SEO metrikleri olarak adlandırılır.

Crawl Budget (Tarama Bütçesi) internet siteleri için iki açıdan oldukça önemlidir ve bu açılır;

- Yeni eklenen bir ürün, kategori, hizmet ya da blog sayfasının erken dönemde taranması ve anlamlandırılması sürecinde arama motoru botlarının internet sitesini düzenli olarak ziyaret ediyor olması hayli önemlidir.

- Mevcut sayfalarda ya da site mimarisinde yapılan optimizasyonların sıralama sonuçlarına yansımasına kadar geçen süreçte crawl budget belirleyici rol oynar.

Google’ın özellikle kullanıcı ve arama motoru beklentilerini tam anlamıyla karşılayan internet sitelerine zaman içerisinde ayırdığı tarama bütçesinin belirgin bir artış gösterdiği görülür ve bu durum çoğu zaman doğru kurgunun da getirdiği performans çıktıları ile sıralama sonuçlarına yansır.

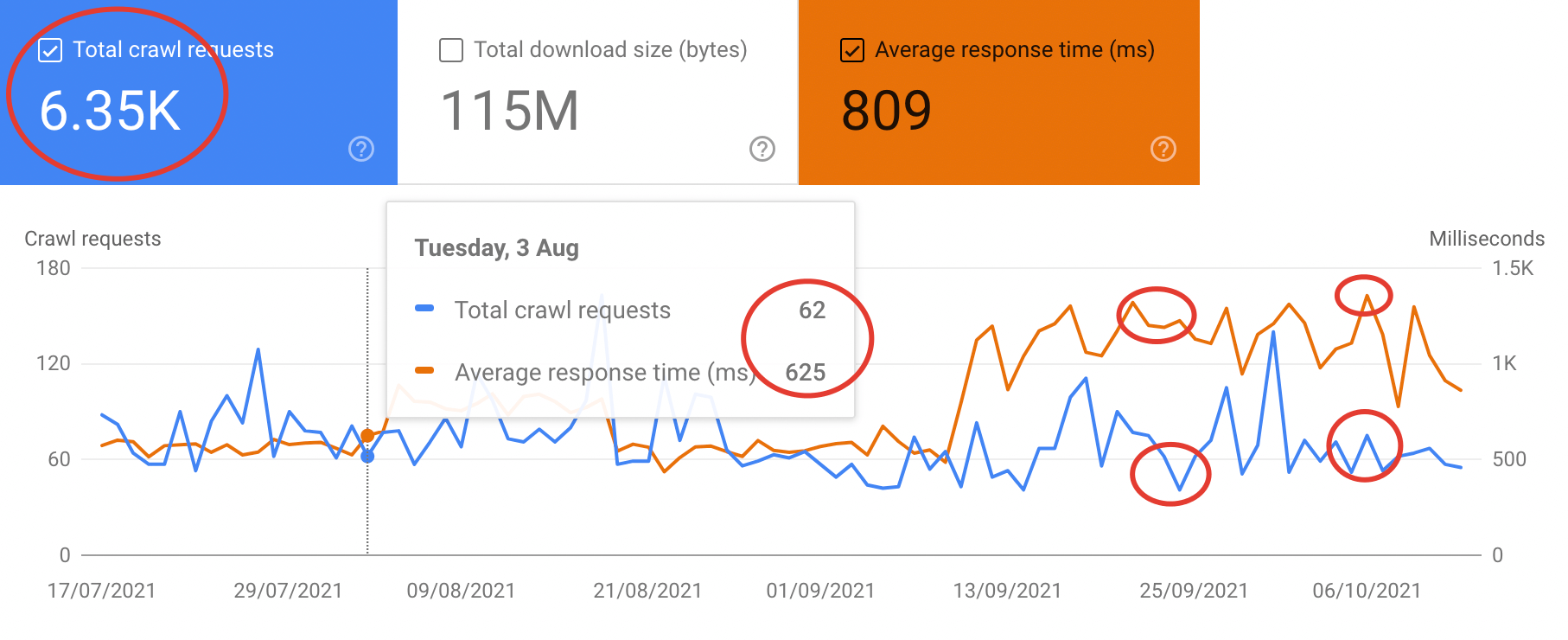

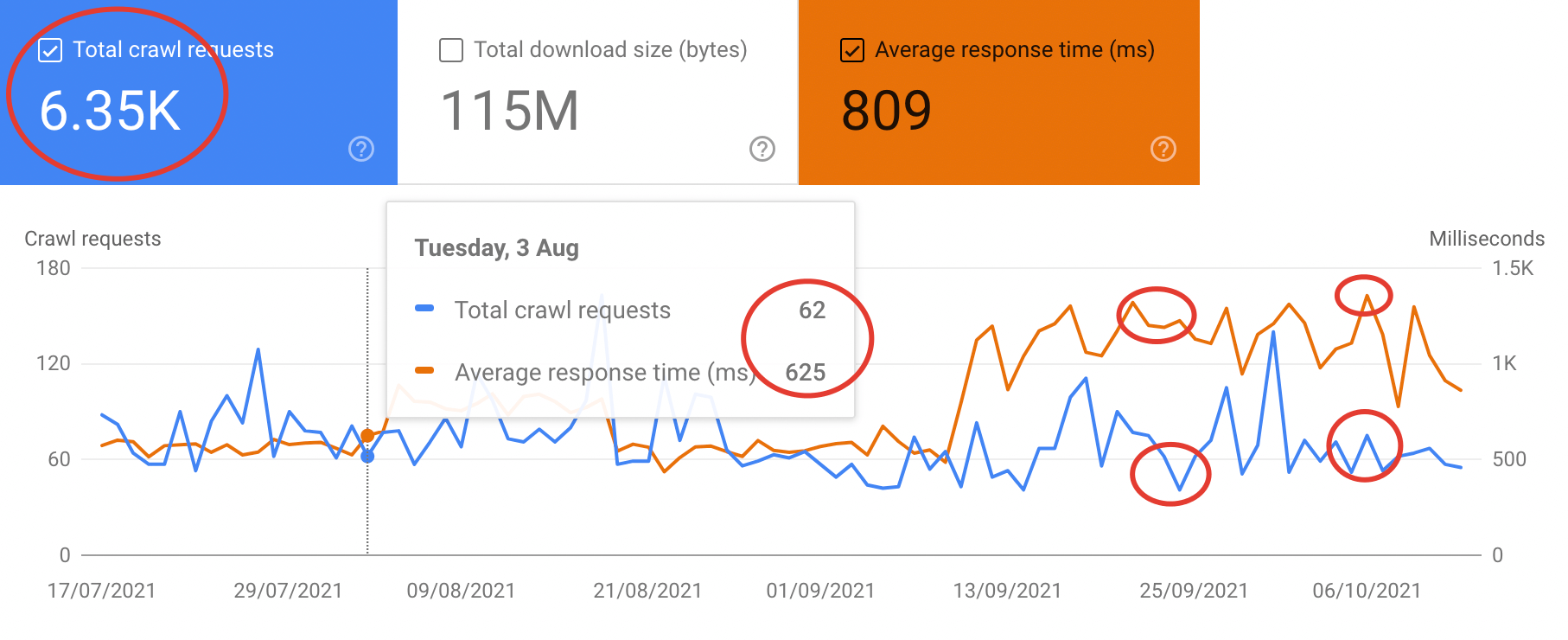

İnternet sitemizde yaptığımız değişimlerin sıralama sonuçlarına erken dönemde yansımasını ve arama motoru botlarının sayfa yapılarımızı anlamlandırmasına istiyorsak Google’a kullanıcılar için değerli sayfalara sahip olduğumuzu göstermemiz gerekir. Bu değeri gösterdiğimiz takdirde paralelde toplam tarama bütçemiz de artış gösterir ve bu değişimi Search Console’un Crawl Stats çıktılarından takip edebiliriz.

Elbette Google’ın ayırdığı tarama bütçesini artırmak adına bir optimizasyon planı yaparken mevcuttaki tarama bütçesini efektif kullanmayı da hedeflemeliyiz. Eldeki tarama bütçesinin hedef sayfalara yönlendirilmesi sürecinin bütününü crawl budget optimizasyonu olarak niteleyebilir, On Page (Site İçi) SEO segmentindeki başat optimizasyonlar ile tarama bütçesinin doğru alanlara kaydırılabileceğinin ve artış göstereceğinin altını çizebiliriz.

Crawl Budget Optimizasyonu

Google’ın SERP’de (Search Engine Result Page) sıralama yaparken temel hedefi; bir hizmet, ürün, bilgi, yorum vb. Arayan kullanıcının arama niyetini karşılayacak sonuçları listelemek ve ihtiyacını mümkün olan en kısa sürede en doğru alanda gidermesini sağlamaktır.

Dolayısıyla Google için tarama bütçesini ayırarak ilgilenebileceği değerli bir internet sitesi olmak istiyorsak, hedeflediğimiz kelime gruplarında yalnızca kullanıcının beklentilerini değil Google beklentilerini de karşılayan sayfa yapıları sunmamız gerekir. Nitekim crawl budget optimizasyonu da bu paralelde gelişir.

Peki internet sitemizin tarama bütçesini optimize ederek hedef sayfalarımızın taranmasını ve anlamlandırılmasını sağlamak adına neler yapmamız gerekir?

Site Hızını Optimize Etmek

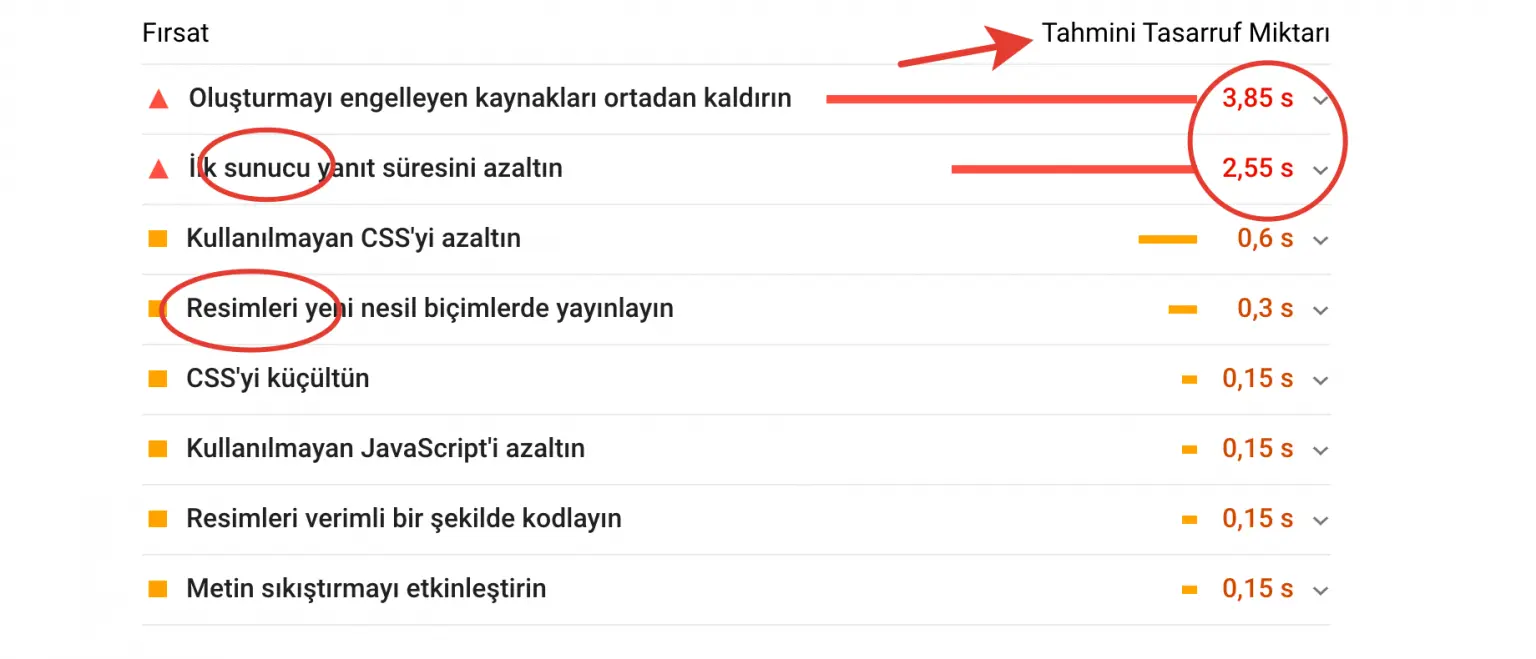

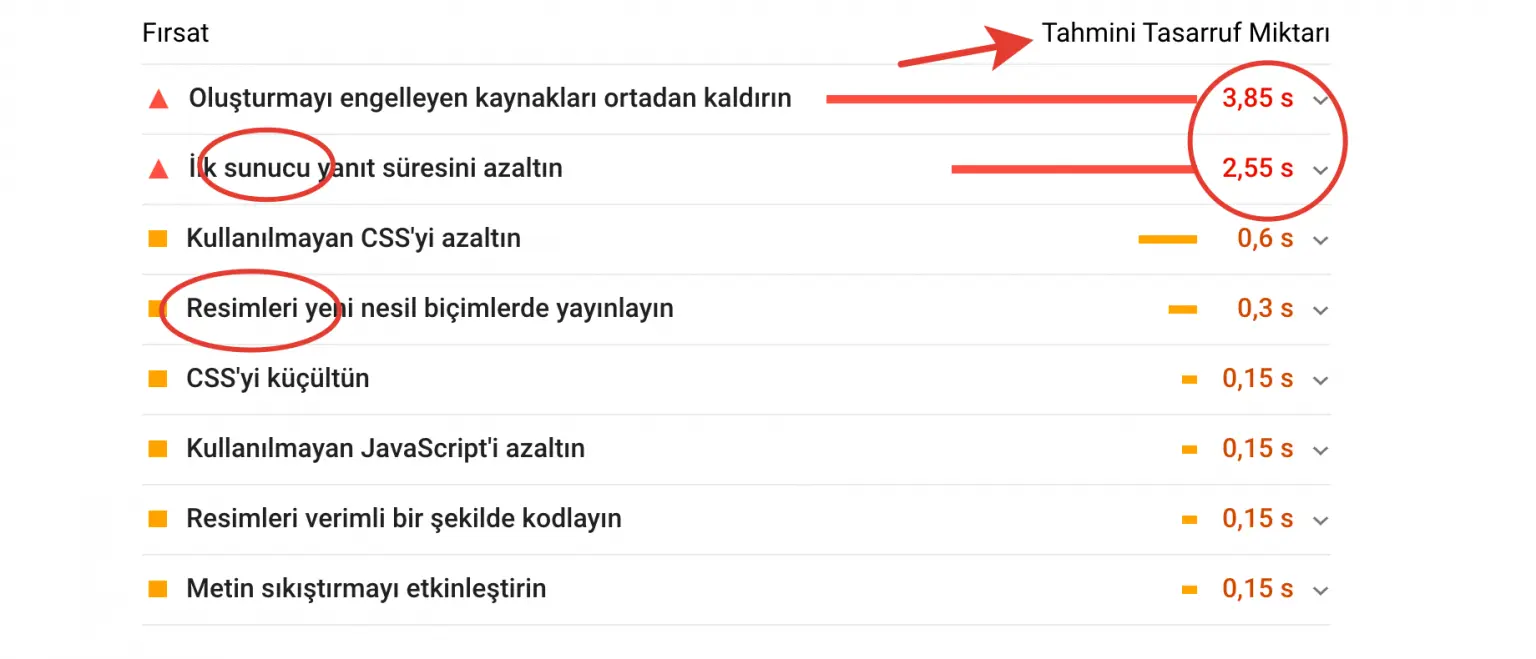

Site hızı, web tasarım sürecinin ilk adımından internet sitesinin kullanıcıları karşıladığı son noktaya kadar kullanıcı etkileşiminin her anında başat öneme sahip unsurlardan biridir ve tarama bütçesi optimizasyonunda da alacağımız ilk aksiyon site hızı optimizasyonu olmalıdır.

Google bot, bir internet sayfasını taramak ve anlamlandırmak için o sayfayı indirir ve indirdiği sayfanın dosya boyutu ve request (js, css vb.) sayısı ne denli yüksekse tarama sürecine de o denli zaman ayırır ve buna bağlı olarak bir sayfa ne denli hızlı yükleniyorsa, tarama bütçesini o denli efektif kullanıyordur sonucu ortaya çıkar. Dolayısıyla eldeki tarama bütçesini efektif kullanarak internet sitesinin geneline yayabilmek adına mümkün olduğunca hızlı açılan sayfalara sahip olunmalıdır.

Site hızı optimizasyonu çok geniş bir alandır ve sunucu performansından görsel formatlarının jpg ve png yerine webp yapısında kullanılmasına kadar birçok detayı kapsar. Yalnızca crawl budget optimizasyonu amacıyla değil, kullanıcının sitedeki ilk etkileşiminden dönüşüm vereceği etkinliğe kadar site içerisindeki deneyimini geliştirebilmek adına da site hızının optimum yapıda olması gerekir.

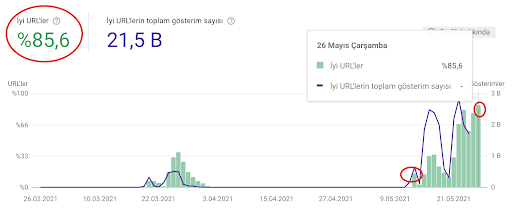

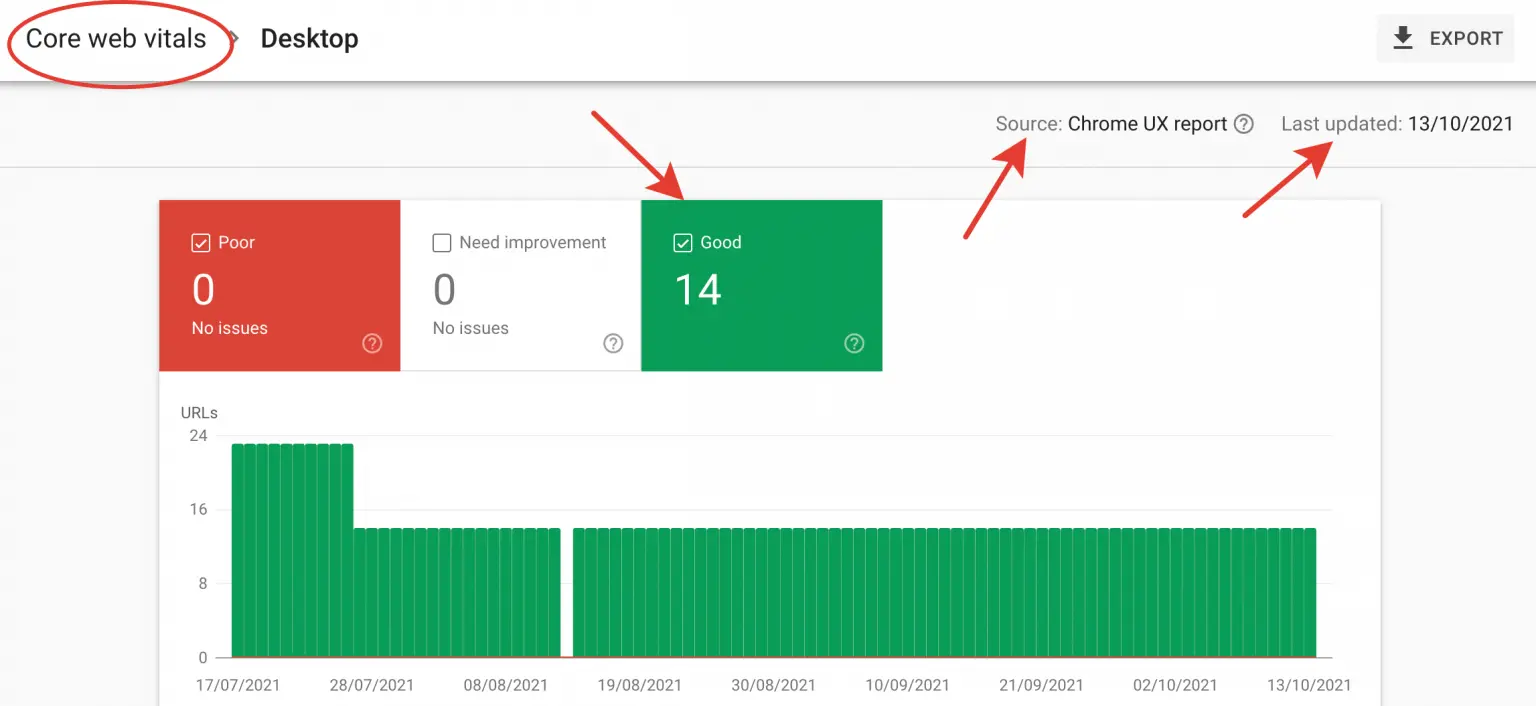

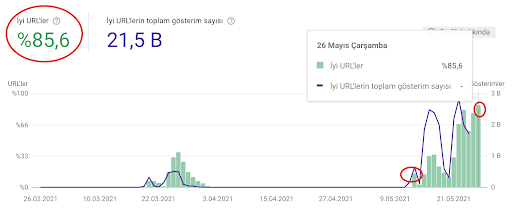

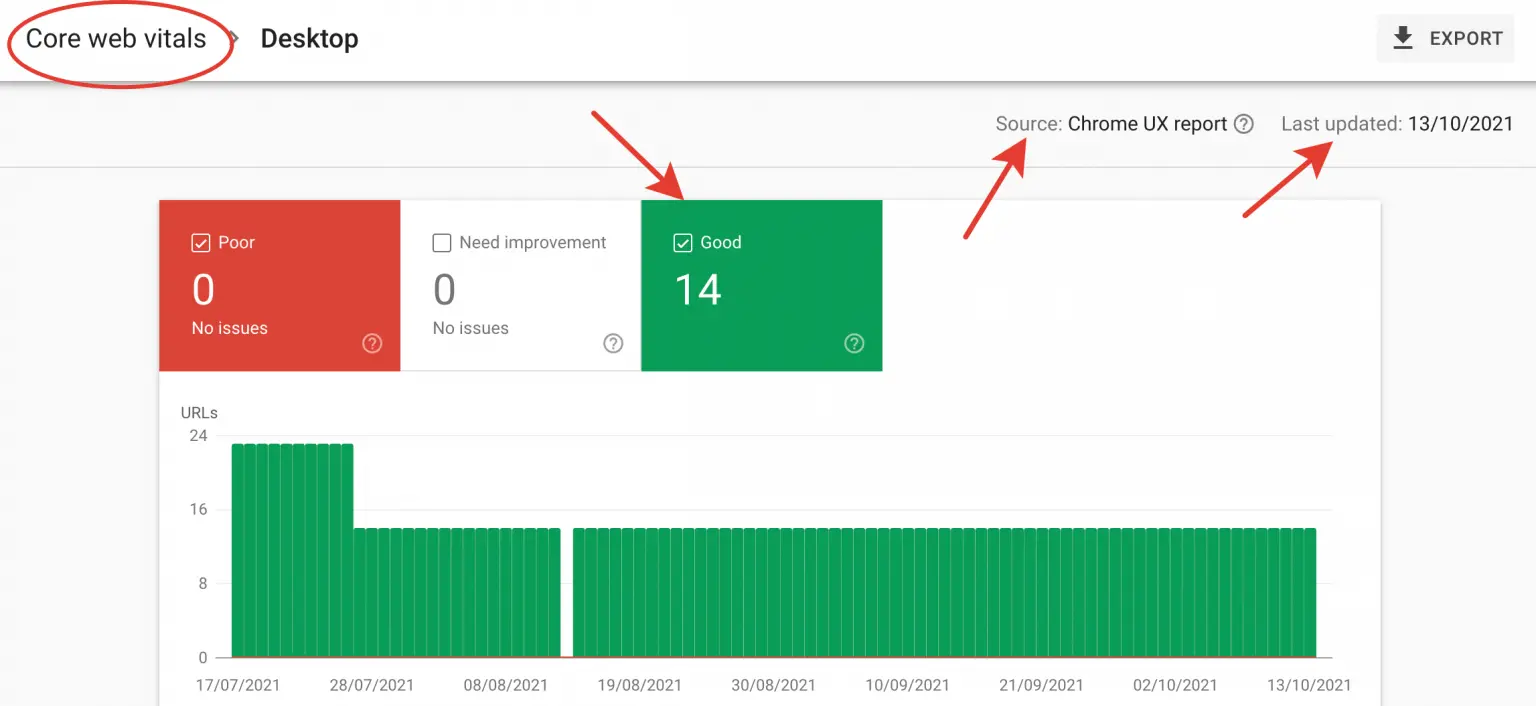

Google, son birkaç yıldaki algoritma güncellemelerinde temel noktalardan biri olan site hızına bütüncül yaklaşarak neredeyse bir yıl kadar önce Search Console’da Core Web Vitals verilerini paylaşmaya başlamıştır.

3xx, 4xx ve 5xx Yanıt Kodlarını Optimize Etmek

Web sayfalarının yanıt kodu olarak döndürdüğü yönlendirmeler (3xx), ulaşılamayan sayfalar (4xx) ve sunucu kaynaklı problemler (5xx) tarama bütçesinin hedef sayfalara aktarılmadan artık akış içerisinde yer almayan sayfalarda eritilmesine neden olur.

Bu nedenle Ahrefs, Semrush, Screaming Frog, Oncrawl, Seolyzr vb. herhangi bir analiz aracılığı yardımıyla internet sitesinin audit edilmesi ve yanıt kodlarının incelenerek varsa 3xx ve 4xx URL’lerin from-to mantığıyla akış içerisinden kaldırılması gerekir.

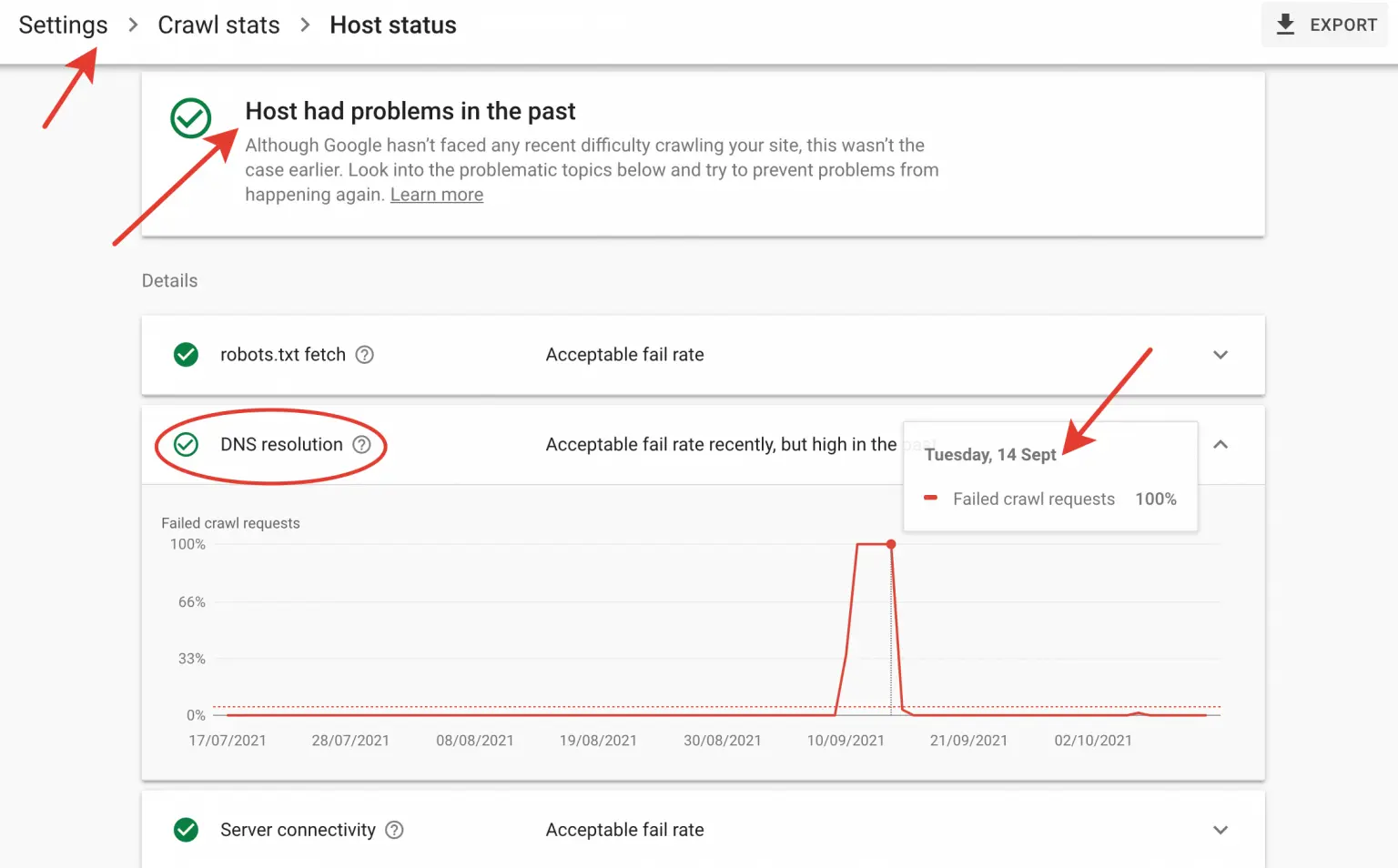

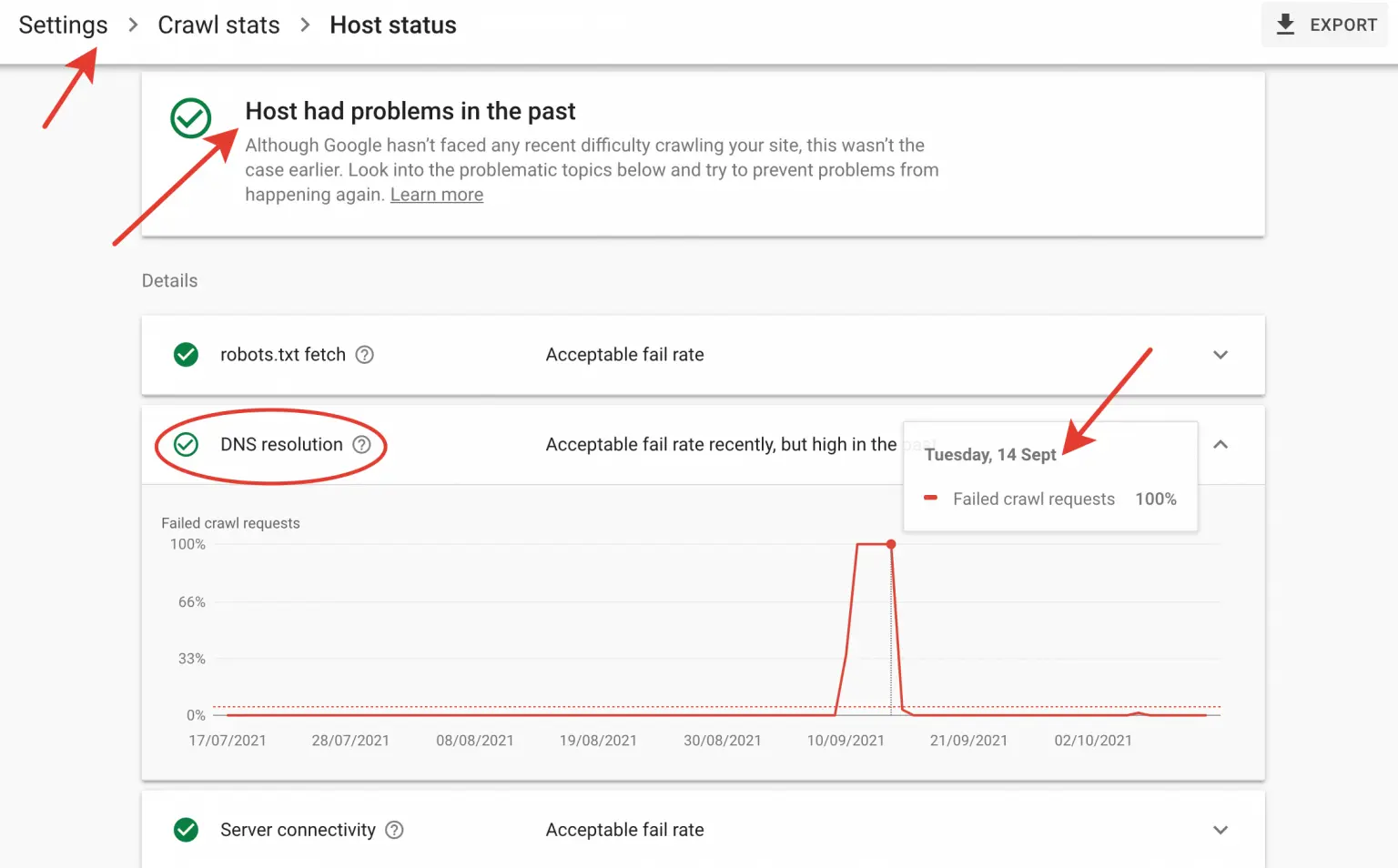

5xx yanıt kodlarını yani sunucuda yaşanan problemleri Search Console aracılığıyla takip etmek mümkündür. Search Console’da Settings sekmesi altındaki Crawl Stats verilerine eriştiğimizde, Host Status alanına bakarak sunucuda herhangi bir kesinti varsa bunun ne zaman ve ne sıklıkla yaşandığını görebiliriz.

Site Haritası ve Robots.txt Dosyasını Optimize Etmek

Site haritası, arama motoru botlarının internet sitesini tararken kullanabileceği bir rehberdir ve Google’dan yapılan resmi açıklamalara göre, site haritası kullanımı zorunlu olmamakla birlikte kullandığı ve Search Console aracılığıyla Google’a iletildiği takdirde crawl süreci üzerinde belirgin bir kolaylık sağlar.

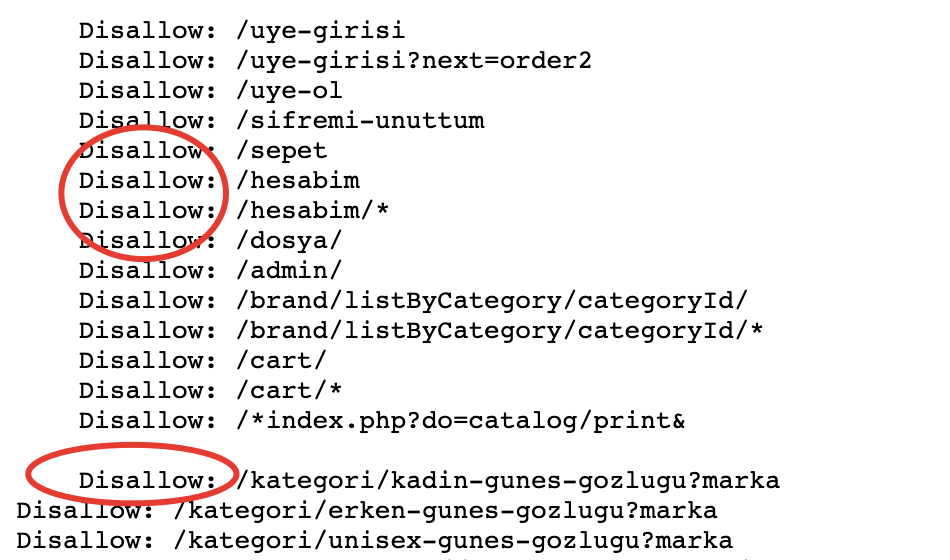

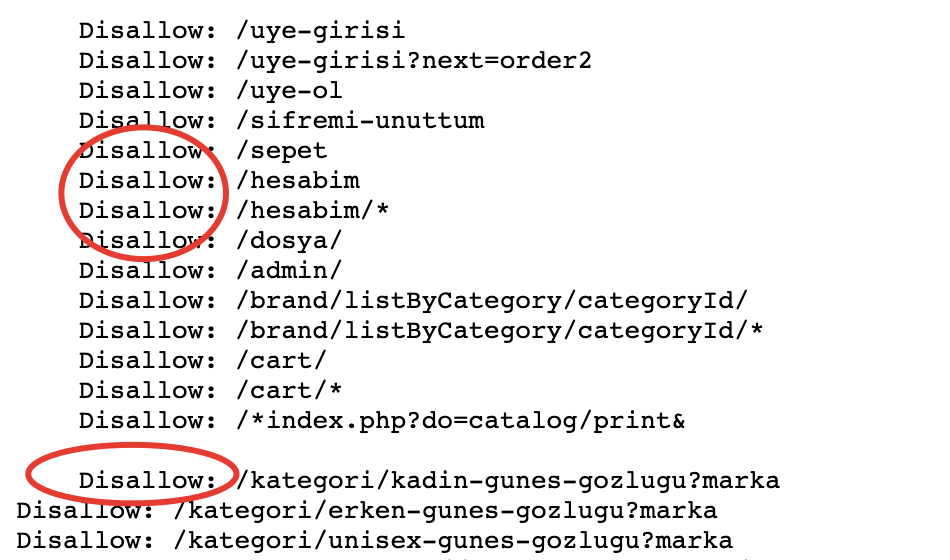

Tarama bütçesini optimize ederken dikkate almamız gereken bir diğer alan da robots.txt dosyasındaki yapılanmadır. Arama motoru botlarının taramasını istemediğimiz sayfa yapılarını robots.txt’de disallow olarak işaretleyerek hedef sayfalarımız içerisinde yer almayan gereksiz alanların taranmasını engelleyebiliriz.

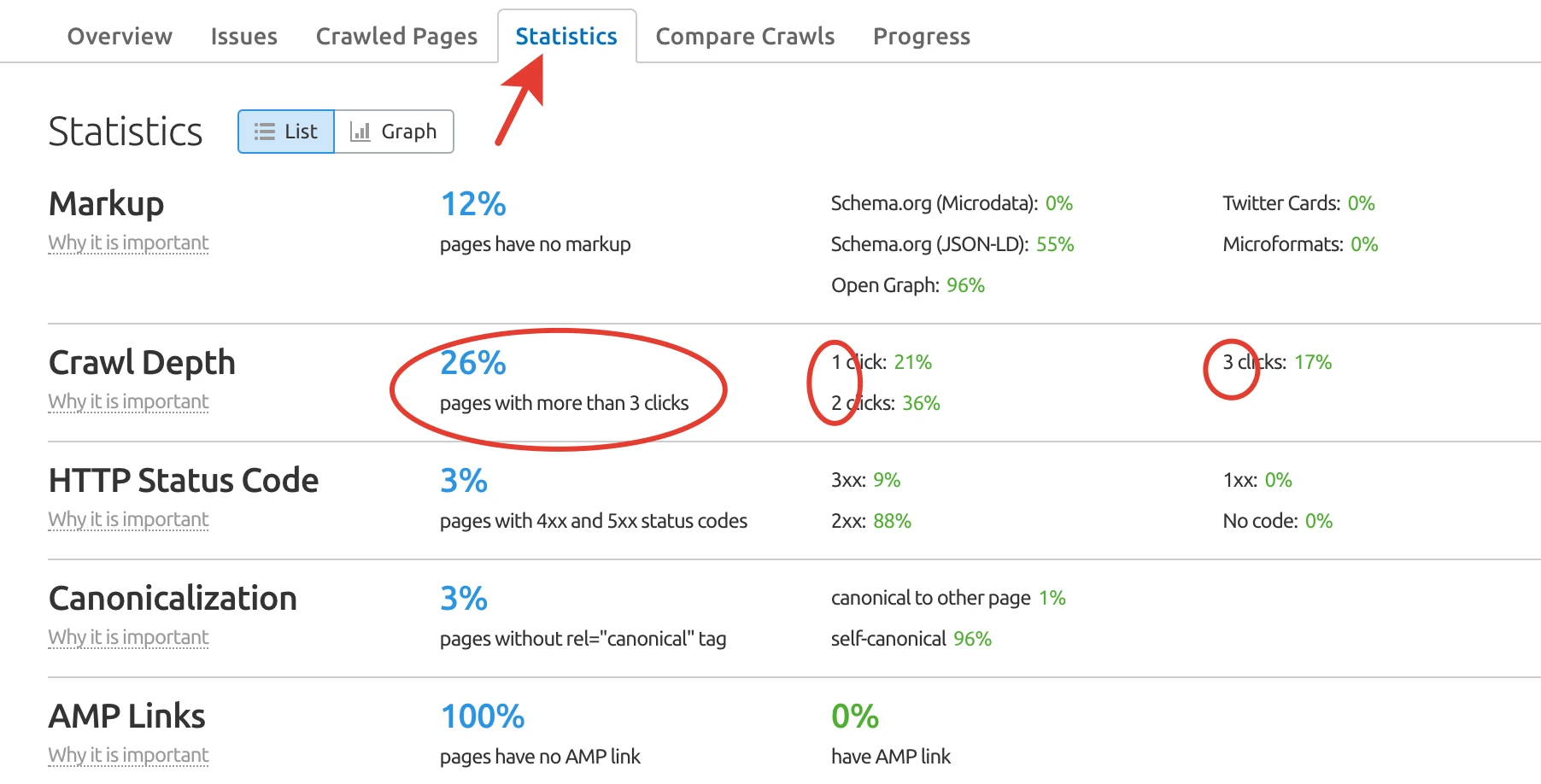

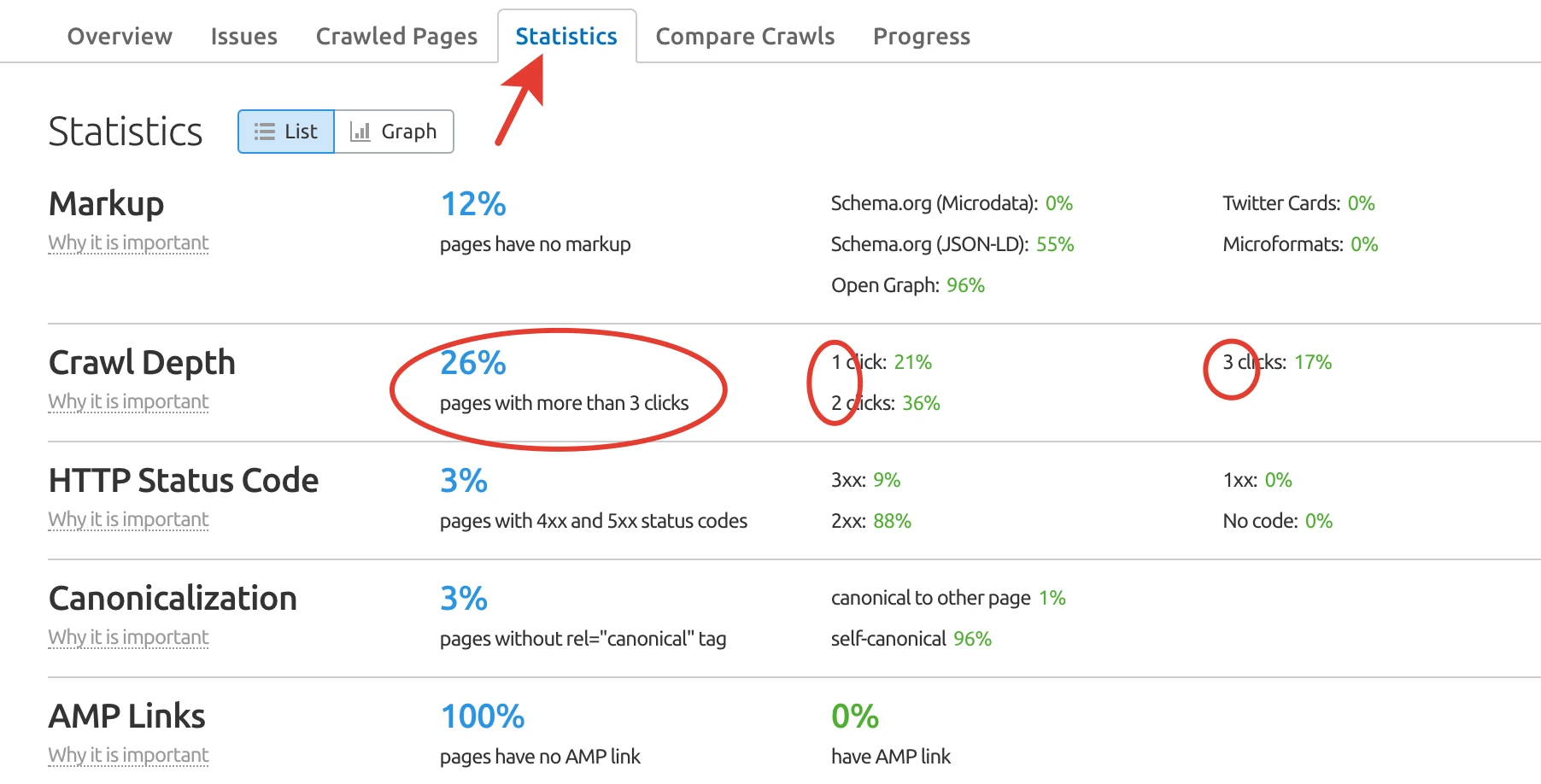

Crawl Depth (Tarama Derinliği) Optimizasyonu

Crawl Depth (Tarama Derinliği) arama motoru botlarının ve kullanıcının, ilgili sayfaya kaçıncı tıklamada yani hangi derinlikle ulaştığını ifade eder. Tahmin edilebileceği gibi birincil öneme sahip hedef sayfaların kolay taranabilir ve ulaşılabilir olması, tarama bütçesinin doğru alana yönetilmesi açısından oldukça değerlidir.

Footer, sidebar ve header alanlarının efektif kullanımıyla gerçekleştirebileceğimiz crawl depth optimizasyonu ile birlikte, kullanıcı deneyimini geliştirecek bilgi mimarisi yapısı da sağlanabilir.

Internal Link Optimizasyonu

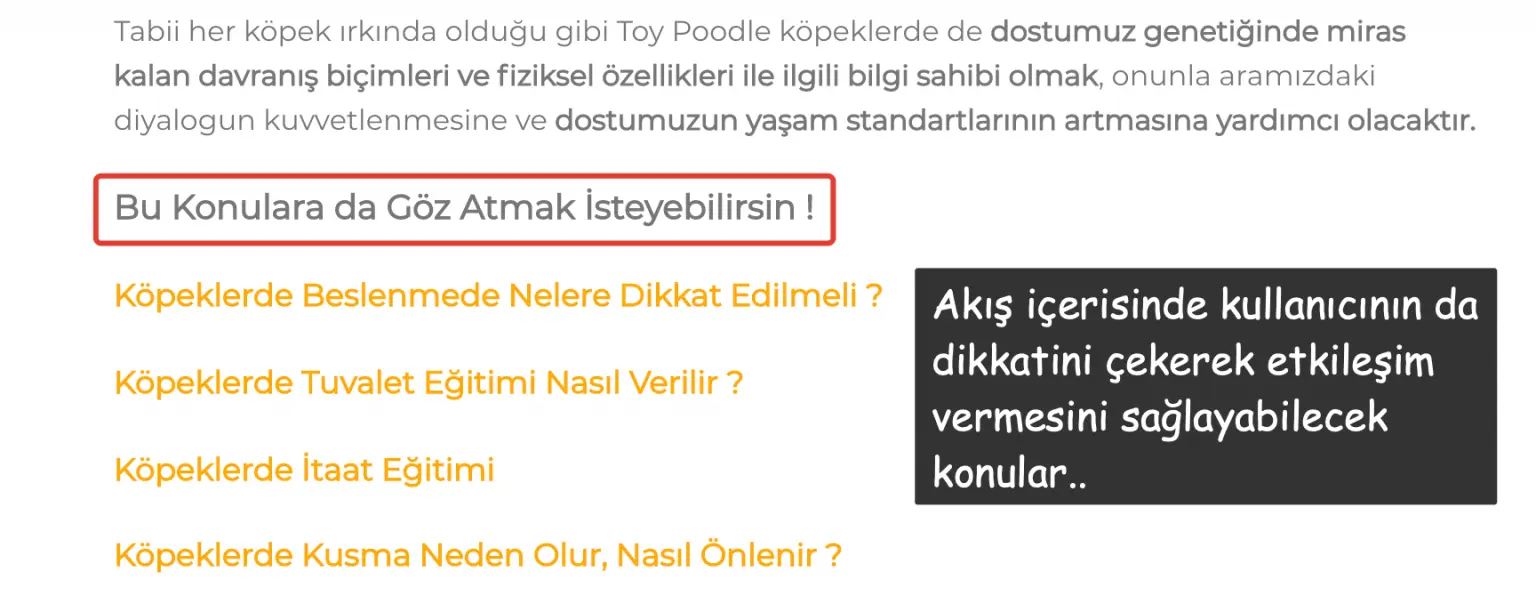

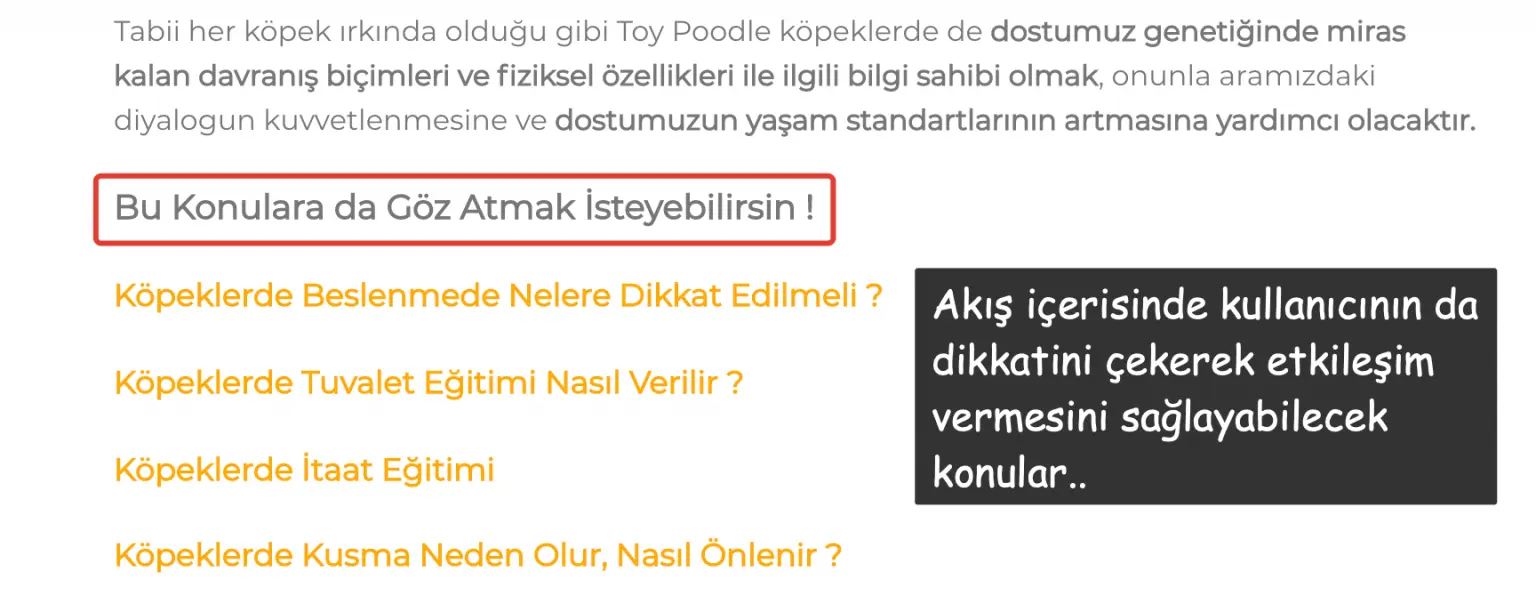

Bir üst satırda ifade ettiğimiz optimizasyon elbette internal (iç) link akışına doğal bir katkı sağlar fakat her bir iç linkin farkı değerlere sahip olduğu unutulmamalıdır.

Örneğin; köpeklerde tuvalet eğitimi hizmet sayfasından doğal akış içerisinde köpeklerde beslenme blog içeriğine geçiş noktası oluşturulduğu takdirde arama motoru botları da bu geçiş noktasını kullanarak yönlenecek, böylelikle internet sitesinin belirli alanları değil bütünü crawl edilerek genel bir performans artışı adına uygun zemin ortaya çıkacaktır.

Backlink Gap Analizi: Off-Page'de Fırsatları Keşfetmek ve Otoriteye Dönüştürmek

Backlink Gap Analizi: Off-Page'de Fırsatları Keşfetmek ve Otoriteye Dönüştürmek SERP Nedir? SERP Özellikleri

SERP Nedir? SERP Özellikleri

Yorum Yaz